■講演内容

|

|

|

- はじめに −基礎科学と社会−

基礎科学の特性について考えてみたい。古代の神話の時代を経て、自然をそれ自体の内部の原理から説明しようとする自然哲学がギリシャやインドで起こった。そこには、デモクリトスの原子論、物体や天体の動き、アルキメデスの数学的な考えなどがある。しかし、それらは、中世の時代の間、無神論として無視されていた。それが近代になり、宗教的自然認識から、経験に基づき、普遍的な反応を示す現象についての学問として、最初に現れたのが物理学や天文学などである。それは、日常の生命維持に直結しないという意味で、人間のもって生まれた知的興味が原動力であったと言える。しかし、今日にまでにつながるような科学的な成果は、パスカルやニュートンが活躍し、英国の王立科学協会の成立(1662年)した17世紀以降である。宗教から離れて、科学が自立できるようになったのがこの時代以降である。その後、19世紀前半までの科学研究は、科学者個人とその弟子のようなグループが、それぞれ活動していた。しかし、19世紀末から20世紀になり、科学は産業の基盤となる技術と結びつき、その社会的意義が大きく変わった。科学研究を進める動機は、科学者の知的興味のみでなく、産業技術をとおして人間の福祉や経済活動の発展、軍事的なものも含むようになった。勢い、科学研究の推進は、政治的なイニシャチブの関与が大きくなった。科学と技術との関係をいうとき、科学でもその先に、技術としての応用につながっている分野と、直接的には人間の福祉に役立たない分野がある。後者を基礎科学と呼ぶことにすると、数学、天文、宇宙や素粒子物理などがそれに当る。その辺を単純にあらわすと図1のようである。

図1 科学と技術

基礎科学の研究は、科学者の好奇心に依存して、社会の構成員の支援によって行う活動である。その成果自身が直接、産業や経済に役に立つことはないため、納税者のパトロンとしての度量に拠っている。したがって得られる成果や結果は、広く公開し、どのような追試にも耐えるものが価値をもつ。最近の研究は、多額の投資が必要であるが、その投資は科学への参加費であり、見返りは、成果を楽しむことである。社会の構成員の知的興味を満たし、その構成社会の知的レベルを計るものでもある。

基礎科学の研究を行うためには、その価値を認める社会でなければならないと同時に、研究装置や施設をつくり出す多様で高度な技術レベルが要求される。さらに、研究活動を支えるIT分野の成熟も要する。常に新しい技術開発による手段をもって基礎科学を追求して、そこから出てきた技術のシーズが、一般社会での新しい応用分野を開いていくことが重要である。このような、科学と技術のサイクルは、5年、10年のオーダーであろうが、このサイクルを止めてはならない。

ここでは、基礎科学の一分野としての高エネルギー物理学に焦点をあてて、その具体的な例を見て行く。

- 基礎科学:高エネルギー物理の発展

高エネルギー物理学の目指すものは、物質のより基本的な構成要素を探ることで、ギリシャ時代から行われたと言われるが、原子の核構造の説が英国のラザフォードによる、実験で確認されたことが出発点ではないかと考えられる。物質の構成要素を次々と掘り下げていくには、それまでは、光による観測であったが、光でなく粒子をつかい、場合によっては、観測の被写体を壊して調べるのは、ラザフォードの実験が最初である。文字通り、高エネルギー物理の発展は、粒子を高いエネルギーにまで加速して、より物質の微細な構造を研究するための粒子加速器の発展とともにある。1930年代は、サイクロトロンが現れ、日本でも大阪大学や理研に作られた。しかし、終戦時に、米軍によって核関係の施設は廃棄させられた。そこですべての日本での発展が停止した。そのころ、米国では、サイクロトロンに変わり、シンクロトロンが考案され、1950年代には、大型の加速器が次々と建設された。高エネルギー物理の黎明期と言える時代を迎えた。

加速器建設から運転に当たっては、多くの要素技術がかかせない。機械設計から、ビーム軌道の計算、精密な機械工作技術、加速空洞の材料と加工技術、大電力高周波発信器、ビームパイプ真空技術、制御技術など、多岐にわたる技術の集大成である。1950年代では、たとえよいアイディアの加速器を作ろうとしても、NCマシンがなく機械加工の限界やビーム安定性の設計のための計算機ミュレーションができなかった。その時代の技術でしかできないにしても、その時々の最高の技術を駆使して、建設されてきた。1950年代後半になると、電子計算機が現れて、その威力は直ちに発揮された。加速器設計の計算、特に、電磁石の2次元磁場計算から、ビーム粒子の軌道計算の初期的な計算がすでに行われた。

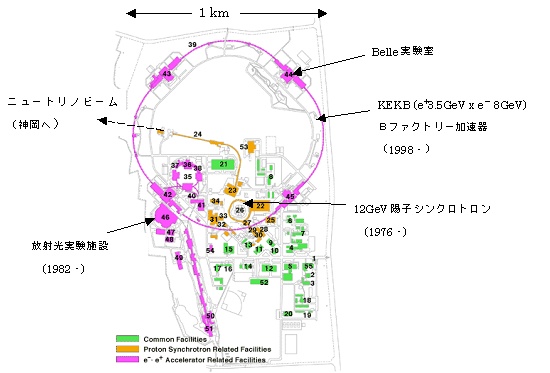

その頃、日本もやっと戦後の回復期を迎えて、高度成長期に向かいつつあるころ、東京大学原子核研究所ができ、加速器の建設がなされた。サイクロトロンと電子シンクロトロンが建設され、日本での高エネルギー物理の草創期である。これには、湯川先生の理論研究の成果も後押しとなっている。この電子シンクロトロンが契機となり、日本でも実験による高エネルギー物理がスタートした。その後、海外での相次ぐ大型加速器の建設に対応して、50GeV陽子シンクロトンを擁する高エネルギー物理学の研究所の設立が計画された。しかし、紆余曲折の末、現高エネルギー加速器研究機構(KEK)の前身である高エネルギー物理学研究所が1971年に、つくばに設立され、4分の1のエネルギーであるが12GeV陽子シンクロトロンが建設された。図2参照。

図2 高エネルギー加速器研究機構(KEK)の加速器(2004)

より高いエネルギーを得るための開発は、世界的にも進められ、ビーム同士を正面衝突させる加速器が、最初はロシアで試験され、その後の高エネルギーを目指す加速器は図3のように、すべてこのビーム衝突型である。日本でも、KEKでは、陽子シンクロトロンによる実験から15年を経て、電子陽電子ビーム衝突型加速器としてトリスタン(TRISTAN)が1986年に建設された。その15年後の1998年には、現在のBファクトリー加速器に転換した。

図3 ビーム衝突型加速器の発展

こうした加速器の高エネルギー化に伴って、粒子同士の衝突により起こる反応を観測するための実験装置も、次第に大規模となった。それとともに、実験は、国際的にオープンな国際共同研究が普通となり、参加する研究者の人数も増加した。それは、高いエネルギーになるほど、大型の実験装置となり、その建設から、実験データの収集、データの解析分析におおくの研究者の参加が必須であるためである。研究者間の情報交換や日常作業の打ち合わせなど、さまざまな場面でのコミュニケーションが非常に大事になった。1980年代より、ネットワークが使えるようになると、高エネルギー物理ネットワーク(HEPnet)として、世界の研究機関が相互に連携して、その発展維持に多大な経済的、人的資源を投入して来た。

こうした加速器を使って、どのような物理学的成果があったのかということと、この後の物理の課題と世界の動向について、少し触れる。高エネルギー加速器といわれるものは、1GeV以上のエネルギーであるとして、そこの研究対象は、原子核の構成要素である陽子、中性子より以上に微細な領域の研究である。これら二つは、まとめて核子とよばれている。この核子を構成しているものは何かをテーマにして、この40年間の研究が行われてきた。核子の励起状態や核子を破壊すると現れる多様な中間子などが1960−80年代にかけて発見されていく中で、それを系統的に理解するモデルが多数検討された。そこから出てきたのが、クォークモデルである。そして、すべての素粒子現象を説明できる標準理論が見出された。物質の構成要素は、3世代のクォークとレプトンからなり、その相互作用はゲージ理論によって定式化された標準理論である。現在の多くの高エネルギー研究は、その確認とともに、それから逸脱するような現象があるのかをめぐって、研究が進んでいる。

最近の日本の高エネルギー物理の実験関係での成果は、世界的にも先導的なものである。神岡やK2Kでのニュートリノの研究では、その質量がゼロでないことを発見した。KEKB加速器によるBファクトリーは、標準理論に基づいた小林益川理論の検証を目指している。また、ヨーロッパ連合の研究所(CERN)での超大型陽子ビーム衝突型加速器LHC(Large Hadron Collider)は、標準理論の根幹をなす、質量起源のメカニズムの鍵であるヒッグス粒子や標準理論を越えるような現象の発見を目指している。

- 基礎科学におけるIT技術の役割

基礎科学における研究には、今でいうIT技術が研究手段の多くを占めている。とくに研究者自身が関わる作業のほとんどがIT関連と言ってもよい。装置の設計、制御、データの収集とその解析、情報交換などである。

1960年代までは、一部の特殊な研究者を除いて、計算尺、手回し計算機が主流であり、コミュニケーションの手段は、手紙とテレタイプであった。しかし、その後は、電子計算機が急速に発展し、その影響は図りしれないものである。研究の手段としての計算機をはじめとするIT技術の利用は、ますます重要となった。それをいくつか挙げると。

加速器の設計

上述したように、加速器の設計は、電磁場計算とビーム軌道の設計計算が重要である。最近は、加速器の制御と連携させて使われている。運転中のパラメータを入れたビームシミュレーションを実施し、より軌道安定性とビーム強度を得る運転状態を探し、ほぼリアルタイムで、フィードバックすることが行われている。オンライン実験

実験でのデータ収集は、リアルタイムでのオンラインデータ収集が、今では当たり前であるが、コンピュータの使い方として、加速器からのビームに同期して、計算機で制御しつつデータを収集する方式は1960年代米国ブルックヘブン研究所での導入が最初であった。リアルタイム処理は、その後、1980年代になり大規模集積回路による論理回路とマイクロプロセッサーを混在させるエレクトロニクスを使うように発展した。さらに最近では、多数のPCを使い、リアルタイムにデータの一次解析まで行う方向にある。データ解析

測定器からのデータは、ビーム粒子と標的粒子の衝突で起こる素粒子反応の結果、発生する各種の粒子の飛跡に沿った点座標とエネルギー、運動量、粒子の種類の同定のためのデータである。このデータから3次元空間の中で、個々の粒子飛跡の空間再構成が主要な計算処理である。事象毎に、独立な現象であるから、個々に平行して処理が可能である。現在では、PCファームが標準的な計算機システムである。PCファームの実用化は、1980年代後半にはすでに、米国フェルミ研究所で始められていた。並列言語PVM, MPIなどの出る以前からである。ネットワーク 情報交換 WEB

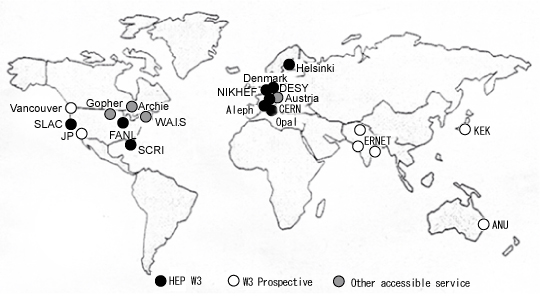

1970年代には、大型の加速器が世界の各地で稼動し、多数の共同研究が始まりつつあった。当時は、連絡の手段としては、手紙であり、テレックス程度であった。しかし、1980年代になると、それまでメインフレームと端末機を結ぶ通信が主であったものが、計算機同士を結ぶネットワークへと発展して、イーサネットがローカルエリアネットワークとして、実用化された。国際間のネットワークは、ようやくBITnet, DECnet, INTERNETが、極く一部で利用され始めている。しかし、高エネルギー分野では、この頃より、高エネルギー物理ネットワーク(HEPnet)として、世界的に相互接続していく体制を整備している。1980年代は、電子メールが主要な利用形態であった。加速器のエネルギーも1TeV近くになり、研究者グループの規模も数百人となり、相互の情報交換の必要性がますます高まっていた。1990年に、CERNで、T. バーナースリーらによって、World Wide Webが発明された。それが数年の後には、世界の情報化社会の基盤になるとは、想像できなかった。当時は、ネットワークとワークステーション、そしてパーソナルコンピュータの時代が開けようとしていた時期であった。同じ研究グループの研究者が世界に散らばっていても、情報を即座に共有できることの意義は、国際共同研究において、計りしれない。1992年の世界のWWWサーバの分布図を下に示した1。これとほぼ、同時期に、電話回線をつかったテレビ会議システムが日常的に使われるようになり、大規模な研究グループの日常的なミーティングを容易にし、国際共同研究の環境が急速に改善されたことは、注目に値する。

第3の研究手法:シミュレーション図4 1992年当時の世界のWWWサーバの分布

加速器による素粒子研究は、新しいエネルギーフロンテアでの実験が次々と行われている。一方、理論の研究の中で、理論自身から実験値を計算して見せることが格子ゲージ理論として提唱され、1980年代には、計算機による第一原理的な計算が始められた。それは、核子の大きさ数フェルミ(10-15m)くらいの時空間を多数の格子に切り、その格子点にクォークを、その間に、力を媒介するグルーオンを配置するシミュレーション計算である。このようなクォークとグルーオンで満たした時空間の状態の多数を計算して、そこから、実験的に求められた中間子の質量とか相互作用の強さなどを純理論から計算するものである。この計算には、膨大な計算能力を必要とし、これまで世界各地のスーパーコンピュータが利用されている。ここでは、スーパーコンピュータは、実験での加速器や測定装置に相当する実験施設である。今や新しいスーパーコンピュータの開発に当り、その牽引役であったり、ベンチマーク的なアプリケーションとなっている。Geant4とプログラム言語

高エネルギーの世界では、CERNやSLAC(Stanford Linear Accelerator Center)が中心になって、データ解析に必要なライブラリを開発して提供していたが、1990年代になり、このようなソフトウエア開発では、限界があり、世界中の研究者が協力していく方向が模索されていた。しかも、従来のFortran言語でのライブラリの整備、維持に限界が見えてきて、オブジェクト指向言語の可能性が追求された。CERNが開発提供していた測定器シミュレーションプログラムGEANTをC++によって書き直すプロジェクトGeant42が、日本の研究者とCERNの研究者が中心となり、世界中のプログラム開発者を募って、1994-1998年に行われた。その成功は、高エネルギー分野での基本プログラム言語をFortranからC++に転換させる大きなキッカケとなった。 - 最近の活動

統合環境 HEP GRID

最近の高エネルギー分野でのIT関連での活動は、データグリッドに代表される。その始まりは、2000年イタリアパドアで開かれたCHEP2000(Computing in High Energy Physics)会議である。それまで計算機科学者の世界では、スーパーコンピュータ同士をネットワークで接続し、アーキテクチャの異なるものをひとつのアプリケーションで使う、メタコンピューティングとして研究が進められていた。それが、より広い応用を対象にしたグリッドコンピューティングに進化し、GGF(Global Grid Forum)が結成されるまでになった。その応用分野として、高エネルギーのような大規模データの広域分散処理をデータグリッドとして、多くの国と地域で活発な研究開発が進められることになる。

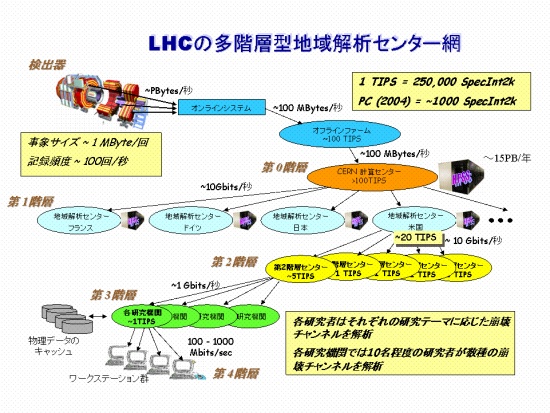

次期の高エネルギー実験の中心であるCERNにおけるLHC実験の膨大なデータを、世界中で共同して解析するための図5のように地域データ解析センター網の構築にグリッド技術の応用を目指している。特に、ヨーロッパ地域は、EUの開発プロジェクトとして、CERNが中心となって、Data GRIDが2001年より開始された。一方アメリカでも、DOE, NSFの支援をうけて、PPDG,GriPhyNプロジェクトが2001年より始まった。これらは、それまで計算機科学者によるシステム開発であったものが、基礎科学への応用を目指した大規模システムの開発となった。

図5 LHC実験のための階層型地域解析センター網構想

現在、CERNに於けるLHC実験のための整備が、LCG(LHC Computing Grid)プロジェクト3として、実運用を目指して、テストが進行している。一方、アメリカは、それまでの開発したものを使って、Grid3として、同様のテストが進行している4。図6参照。しかし、現在進行中の大規模実験グループは、慎重にシステムを選択して実際の応用に適応しつつある。米国のBaBar, CDF, D0実験、日本のBelle実験グループなどである。

図6 高エネルギー分野でのデータグリッド整備プロジェクトでの構成サイトとその計算機資源などを示す。NORDUGRIDは、北欧地域のプロジェクト。

これらの成果をもとに、2004年からはつぎのステップに移行しつつある。ヨーロッパ地域では、EUのEGEE(Enabling Grids for E-science in Europe)プロジェクト5として、また、アメリカでは、Open Science Grid6として、より広い研究分野での研究環境の基盤としての整備が強力に進められている。

デジタルデバイド

上述のような国際間の広域ネットワークによるデータグリッド網の整備につれ、東欧、南米、アジア地域の発展途上国の研究者は、そのネットワーク環境の遅れに危機感を深めている。そこで、各国の高エネルギー研究者は、国際的な共同研究するためのネットワーク整備がその国の経済社会の発展にも貢献することを訴えて、国際的な高エネルギー物理のコミュニティと連携してデジタルデバイド解消にための活動をしている。そのため、コミュニティとして、各国でワークショップを開いたり、技術者の教育などにも協力している。

オープンソースとLINUX

1990年代ITの世界からオープンソース文化が立ち上がり、そのプロダクトは、基礎科学研究の分野に、非常に大きな影響を与えている。多くの有用なソフトウエアが研究者により開発され、それを"興味をもつ開発者も利用する人も皆"で、改良整備してよいものとする。この文化の果たす役割は、今や非常に大きい。現在では、研究開発の分野では、主流となりつつある。

そのようなオープンソースの代表として、Linuxは、ビジネス分野も含めて利用される状況になった。高エネルギーの世界でも、今やLinuxが主流となり、発展途上国の研究者にとっても多くの恩恵を与えている。さらに、最近では、米国フェルミ研究所が中心となり、研究に利用するLinuxディストリービューションとしてScientific Linux7を提供し始めている。従来のRedHatからScientific Linuxに統一して行こうとする方向にある。このScientific Linuxを世界中の高エネルギー研究での標準にすることに成功すれば、他の研究分野への影響を与え、ITの世界にも、なんらかの影響があるのではと注目される。

- 今後の発展への期待

この高エネルギーの研究分野で、IT関連の動きは、10年毎に新しい潮流が生まれている。1960年はオンライン、1970年は大型計算機によるデータ処理、1980年はネットワーク、1990年はWWW、2000年はデータグリッドである。それぞれの時代の技術を利用しつつ、次の方向を目指して、開発研究が行われて来た。

最近の半導体技術の進歩は、一時期の限界説を覆して、さらに高密度化、低電力化を目指して続いている。今やコストパフォーマンスの良い計算機がふんだんに利用できる状況になり、基礎科学での研究手法が大きく変わりつつある。従来のように大型システムを共用するより、個々の研究者が個別に高性能な計算機システムを占有でき、多くの市販の研究支援プログラムが利用できる。専用ゆえに、CPU時間で1週間とか1ヶ月などの長時間ジョブでも可能である。とくに、シミュレーションのような研究課題では、研究者に多くの自由度が与えられたと言える。

特に、スーパーコンピュータのアーキテクチャもベクターから超並列のスカラーとなり、大規模な計算も、過日に比してふんだんにできるようになった。従来は、物質、分子、原子と階層の異なる現象は、それぞれ個別に扱って研究していたものが、複数の階層に亘る物理過程を同時に扱うことも工夫され、新しい研究分野、研究手法を生みつつある。それに伴う、異なるアーキテクチャの大規模計算システムを協調して稼動させる技術の進展を促している。プログラム言語もFortranに限らず、C言語やC++なども利用する方向にある。

今や、ITといえば、ワイヤレスも含めて、ネットワークなしには語れない。先にもふれたデータグリッドへの展開は、現在プロトタイプとしてのシステムの整備が進んでいる最中で、その行き着く先が必ずしもバラ色か否かは、ここ数年の進展を見なければならない。グリッド技術の実用化は、IT技術の進んで行く方向の一つであることは間違いないが、ミドルウエアの標準化、セキュリティの確保、サービスモデルの確立、ネットワークを含む運用のための環境整備、資源の共有のインセンティブの確立など多くの課題が残されている。これらの問題をかかえながらも、高エネルギー物理での次世代の実験研究に適用していくべく、大変な努力が世界中でなされている。それの最大のモチベーションは、基礎科学としての高エネルギー研究の学問的な意義にあると同時に、グローバルに展開した多数の地域解析センター間を10 Gbps級の超高速ネットワークで結び、超大規模なデータを共有し、数千人の研究者が世界中に配置した計算機資源を奪い合うようにデータの解析する大規模なシステムを実現することは、次世代の社会インフラとしてのグリッドの作る世界のモデルであろう。

2005年は、アインシュタインの相対性理論から、100年目になり、世界物理年としていろいろな行事が計画されている。基礎科学の発展とIT分野のみならず関連技術の発展は、深く結びついている。将来とも相互に影響し合い展開していくことに、大きな意義がある。

1 Tim Barners-Lee et al. Proc. of CHEP1992, p69

2 http://www.geant4.org/

3 http://cern.ch/lcg/

4 http://www.ivdgl.org/grid3/

5 http://www.eu-egee.org/

6 http://opensciencegrid.org/

7 https://www.scientificlinux.org/